王兴一鸣惊东说念主!好意思团首个开源大模子追平DeepSeek-V3.1

没料到啊,最新SOTA的开源大模子……

来自一个送外卖(Waimai)的——有两个AI,如实不通常。

这个最新开源模子叫:Longcat-Flash-Chat,好意思团第一个开源大模子,发布即开源,如故在海表里的技艺圈子里火爆热议了。

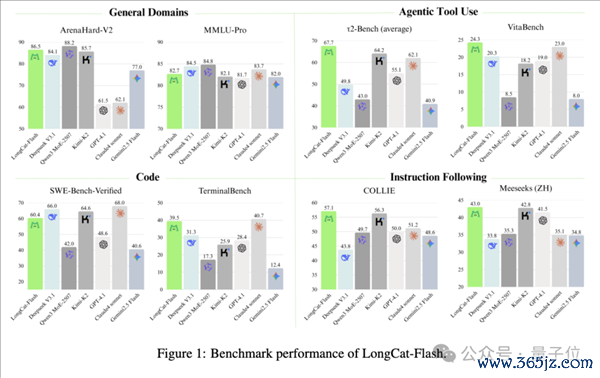

一方面是因为获利亮眼:

它在部分benchmark上,比如Agent器用调用、提醒恪守的证实逾越DeepSeek-V3.1、Qwen3 MoE-2507,甚而比闭源的Claude4 Sonnet还要好。

编程能力也值得眷注,在TerminalBench上,和公认的“编程之王”Claude4 Sonnet不相坎坷。

比如相配流行的小球氛围编程测试,LongCat编写的形状,运行起来着力是这么的:

另一方面是技艺禀报中领路出不少好意思团关于大模子的明白,包括DSMoE、MLA、动态臆测、Infra等等。

我认为这是中国大模子里最讲得详备的论文了,甚而逾越Kimi、GLM,尽头是在建模和infra方面。

要知说念,这但是一家“外卖公司”啊(手动狗头),作念的模子都比Meta好了。

而且不光是模子性能好,技艺禀报里还先容了一系列新发现,比如:

接受新路由架构,调用真的需要的巨匠模子,使臆测更少;通过将MoE和密集层的通讯访佛实行,优化模子通讯着力;使用新步调来移动超参数而不是muP……

以及岂论是在总参数目照旧激活参数上,Longcat-Flash-Chat都比DeepSeek-V3.1和Kimi-K2更少。

具体来看——

“零臆测巨匠”让迷糊大幅晋升

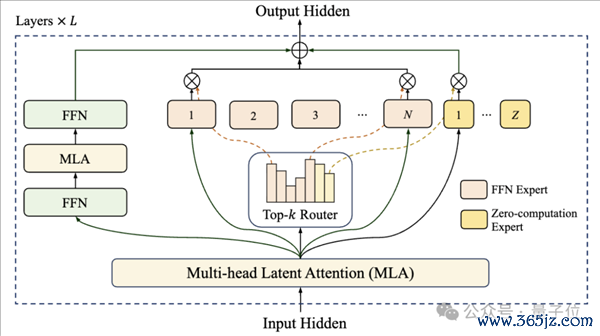

这次开源的Longcat-Flash-Chat是一个560B的MoE模子,举座架构接受“零臆测巨匠”(Zero-computation Experts)与Shortcut-connected MoE双重筹画。

它通过凭据坎坷文要紧性为每个token动态激活18.6B–31.3B参数,并让前一块密集FFN与面前MoE的通讯阶段并行实行,大幅晋升测验与推理迷糊。

比拟于同为MoE架构的DeepSeek-V3.1(671B/A37B)和Kimi-K2(1T/A32B),Longcat-Flash-Chat都领有相对更少的总参数目和激活参数目。

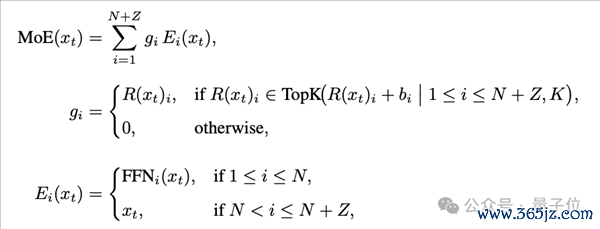

零臆测巨匠是在巨匠池中加入的几许恒等巨匠,路由器为每个token从N+Z个巨匠中收用K个,被选中的零臆测巨匠平直恒等映射输入,都备不作念GEMM运算,已毕动态臆测分派。

为保合手约27B激活参数,系统通过巨匠偏置+PID死心器在线调换路由概率,并引入开辟级负载平衡吃亏对FFN与零臆测巨匠进行分组经管,幸免序列级失衡。

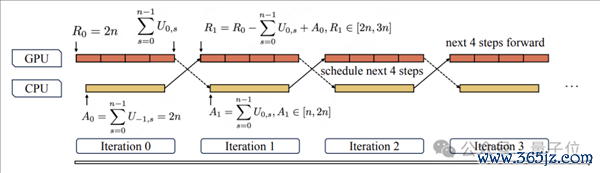

Shortcut-connected MoE通过跨层快捷畅达重排实行活水线,使上一层FFN臆测与面前层dispatch/combine通讯并行,权贵扩大臆测-通讯访佛窗口。

范畴化测验经由中,LongCat接受了“超参数移动+模子孕育动手化+多重踏实性套件+服气性臆测”的策略组合,即先用小模子展望最优超参数,再将14层模子堆叠成28层checkpoint加快连接。

能力塑造方面,模子先在两阶段和会的20T token语料上完成预测验,中期强化推理与编码并将坎坷文窗口膨大至128k,最终借助多Agent合成框架生成高难度器用使用任务进行后测验,使模子具备复杂agentic活动。

推理阶段,为透澈排斥CPU调度与Kernel启动瓶颈,团队已毕多步访佛调度器,一次性为改日n步预排并启动前向,使CPU调度与GPU臆测交错,配合其他技艺,使得LongCat在560B级别模子上已毕迷糊的大幅晋升。

最终,LongCat-Flash在多类泰斗基准中处于第一梯队,在非想考大模子中与DeepSeek-V3.1等模子相配甚而更优。

性能上,与DeepSeek-V3等同级模子比较,LongCat-Flash在不同坎坷文长度下都已毕了更高的单GPU迷糊和单用户速率。

560B参数的LongCat-Flash在上万个加快卡上完成逾越20Ttoken预测验仅用30天,测验时代可用率98.48%,单张H800GPU生成速率逾越100 tokens/s,本钱约0.7好意思元/百万输出token。

实测好意思团LongCat大模子

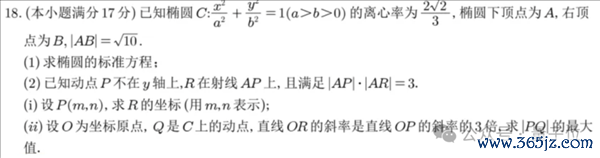

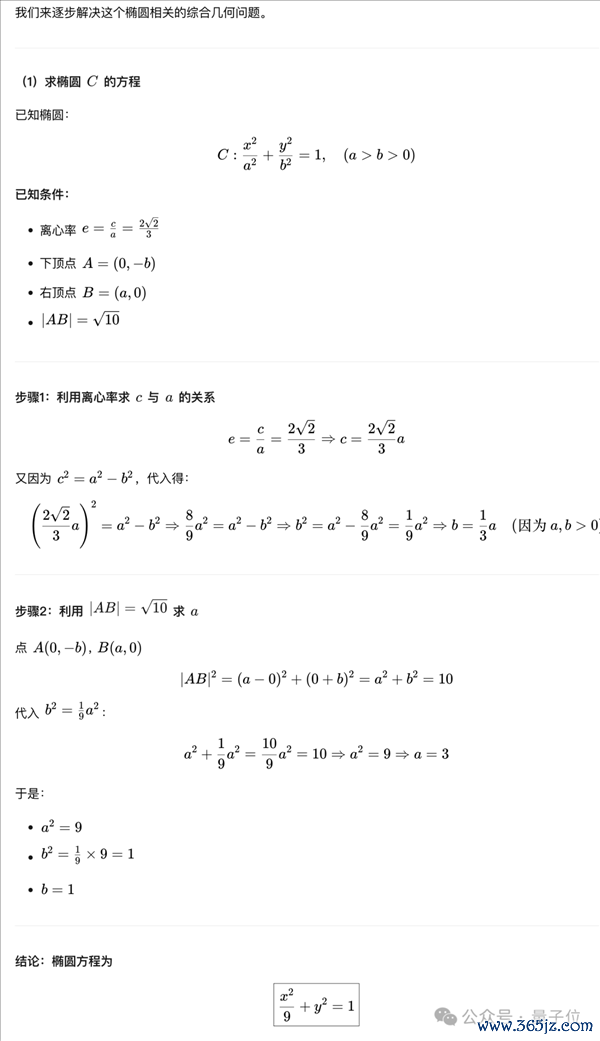

那么接下来,就来望望LongCat的真实证实,咱们跳过浅近的基础问答,平直上数学题。

这说念题出自本年的世界一卷。这里题目是以文本形状输入给模子的,且公式转机成了LaTeX形状。

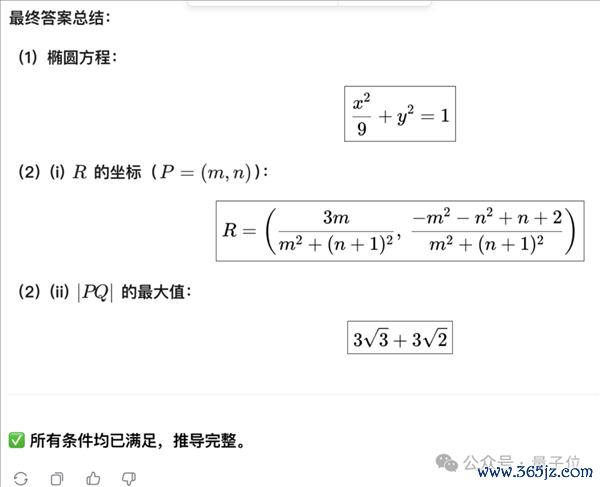

先看末端,LongCat的最终谜底全部正确:

接下来查抄一下具体经由。

第一问在圆锥弧线类问题当中比较基础,浅近连系已知信息,旁边离心率的界说式然后代换数目讨论就能解出,LongCat也作念对了。

第二问的第一小问,LongCat凭据R处所射线AP的办法向量,连系新设的未知变量抒发了AP和AR的模,然后代入已知要求求解未知变量,最终奏效处罚。

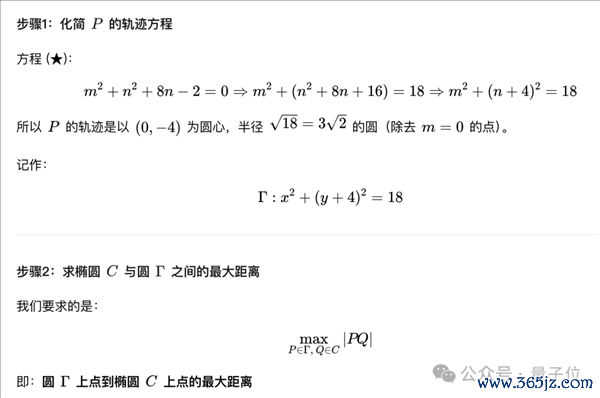

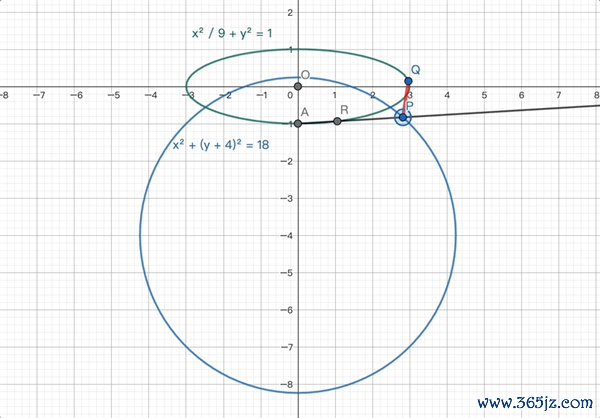

第二小问中,LongCat先连系了上一问的末端以及新要求,通过臆测取得了一个要津的中间论断——点P位于一个圆心和半径均已服气的圆上。

要是遐想不到,这里有一个浅近图示。

旁边该论断,LongCat对最大距离进行了拆解,并通过代入等步调,最终臆测出了正确末端。

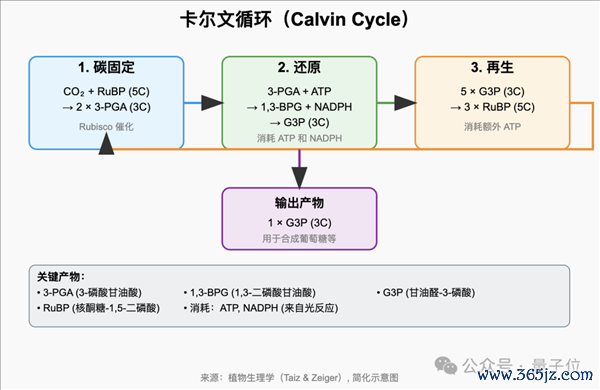

接下来是一项轮廓能力测试,画图生物学当中光结合用当中卡尔文轮回的SVG默示图,SVG是一种用代码闪现的矢量图形。

接下来是一项轮廓能力测试,画图生物学当中光结合用当中卡尔文轮回的SVG默示图,SVG是一种用代码闪现的矢量图形。在这么的任务中,模子不仅需要对所画图内容的布景学问有鼓胀了解,还要有鼓胀的空间遐想力对内容进行布局,终末还需要写成代码,这么的任务是一个相配复杂的链条。

大书特书,咱们对LongCat给出的SVG代码进行了可视化,总的来说,LongCat比较告成地完成了图示的画图。

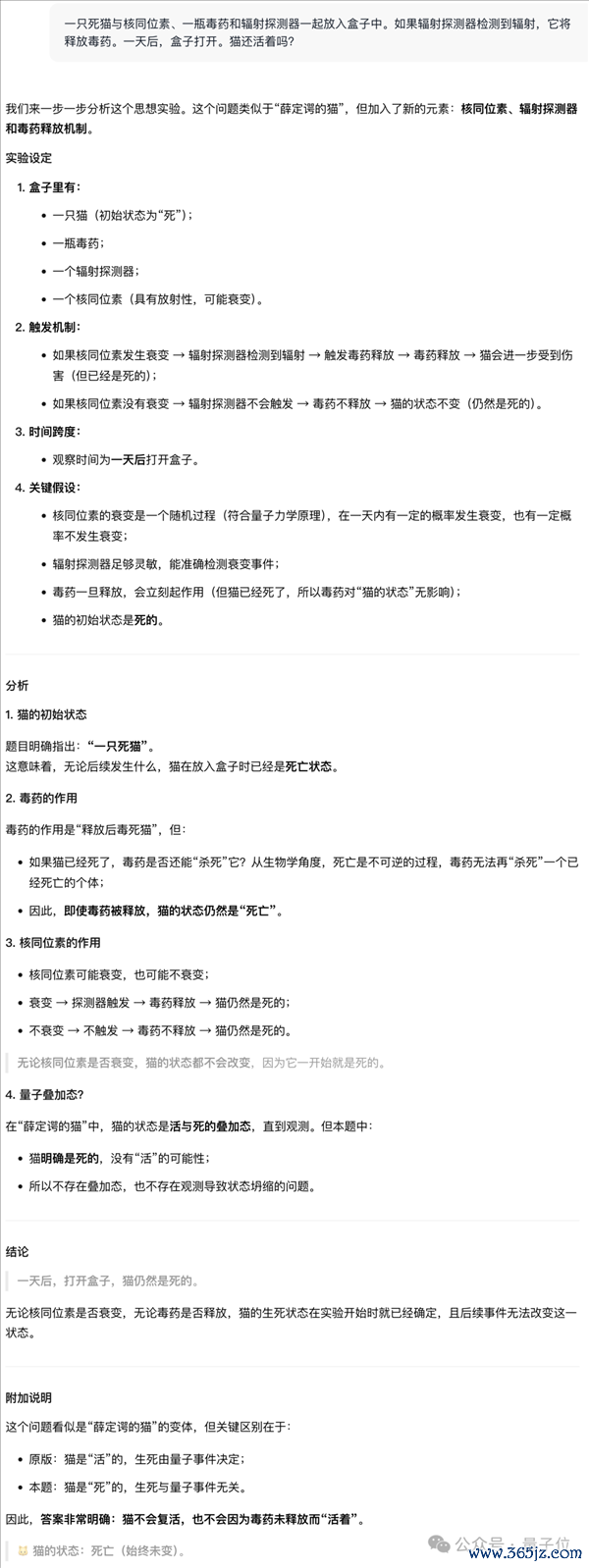

终末是一说念蛊惑性问题,题目出自GitHub上一个名为Misguided Attention的Benchmark。

其中包含了许多经典谜题……的改编版块,锤真金不怕火的即是大模子能不成作念到不被局势蛊惑。

比如物理学当中的名场合——薛定谔的猫,在这套基准当中,这只猫的“猫设”被改成了一只故去的猫。

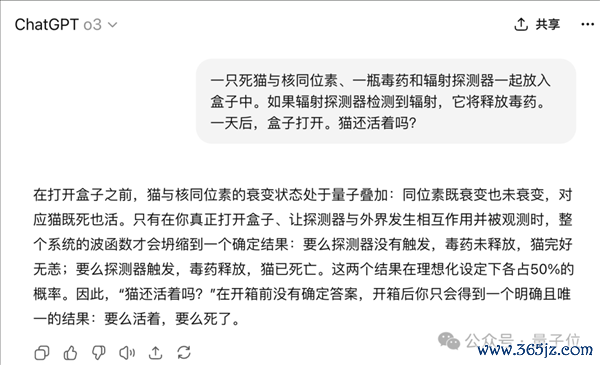

一只死猫与核同位素、一瓶毒药和发射探伤器一说念放入盒子中。要是发射探伤器检测到发射,它将开释毒药。一天后,盒子开放。猫还辞世吗?

末端,LongCat平直看穿罗网,明确指出既然是死猫那就莫得存活的可能性,何况还指出了这说念题与原版“薛定谔的猫”的要津分歧。

而o3就莫得矜重读题,照旧按照传统的薛定谔的猫那一套进行的复兴。

“外卖公司”何如在作念大模子?

这次激勉国外热议的还有一个原因在于好意思团给他们带来的反差感。

许多东说念主浅近残忍把好意思团明白为一家外卖公司。尽管他们之前之前有无东说念主送餐积攒下来的了动驾驶、机器学习的基础,但是大模子都备是另一条技艺线了,是以这次开源更会让东说念主认为是“横空出世”。

不外梳理好意思团在大模子波澜后的AI动向,这次模子开源也就不那么未必了。

2023年,王慧文摇唇鼓舌自带5000万好意思元配置光年除外,并吸收一众AI界限顶级东说念主才团队加盟。后续由于王慧文个东说念主健康原因,好昆季王兴兜底,好意思团于是接办光年除外,现存团队将络续研发大模子。

同庚,由好意思团里面寂然AI团队GN06开发的AI神气陪同家具Wow上线,这亦然好意思团发布的第一个寂然AI应用。

2024年4月,病休的王慧文以照管人身份转头好意思团,11月矜重疏导GN06团队。

GN06在好意思团的定位是一个相对寂然的AI团队、不附庸于任何事迹群,专注于探索主贸易务除外的转变AI应用。

2024年他们还推出了一个AI图像生成应用“妙刷”。

在2024年6月,GN06的招聘需求显然加多,范围掩饰前端、客户端、后端、家具、运营、商分等。

2024财年岁迹发布会上,好意思团还矜重明确了“主动进击”的AI策略。

好意思团CEO王兴初度发达了公司的AI政策布局,主要通过三层架构鼓吹技艺落地:

AI at Work:指标是旁边AI器用晋升逾越10万名职工的责任着力。AI in Products:旨在用AI矫正现存家具并创建原生AI应用。Building LLM:合手续参预资源自研大模子。

那时就如故提到了Longcat大模子,领路该模子连系外部模子为职工推出了多种AI器用,包括AI编程、智能会议、文档助手等,并领路了LongCat API的调用量占比从上一年年头的10%增长到68%。从这个信息推断,Longcat在至少在2024年头就如故不错落地应用。

另外皮研发参预上,2024年好意思团参预211亿搞研发,范畴仅次于华为、腾讯和阿里巴巴。往时5年研发参预冲破1000亿元。

家具连系方面,好意思团测试推出了问小袋、米鲁等AI智能助手,用于餐饮保举、问答交互等。

在这种政策下,2025年好意思团在AI办法的动作愈加显然起来。

比如前段时刻还推出了AI编程应用NoCode,撑合手前段开发、数据分析、运营器用和派系网站生成等,技艺小白也能用;同期里面也有CatPaw对标Cursor,缓助开发者写代码。

总体来看,以好意思团的研发储备,开源一个大言语模子并不虞外。

不外也不同于AI公司,好意思团的AI布局更多以业务场景驱动为中枢,贯注在实质应用中的落地着力。

这种策略不错回首到2021年、大模子波澜之前,好意思团集团政策从“Food+Platform”升级为“零卖+科技”,明确将AI、机器东说念主、自动驾驶等手脚改日中枢办法。

比如在愈加早期的具身智能界限,好意思团已屡次动手,投资了宇树、星海图、星河通用、它石智航等头部梯队公司。

你用来拼好饭的好意思团,如实不是单纯送外卖的好意思团。

固然外卖大战依然火热,但用AI的视角扫视好意思团,亦然时候了。

职守剪辑:随性著作内容举报

]article_adlist--> 声明:新浪网独家稿件,未经授权禁绝转载。 -->